GPU (Graphics Processing Unit) — это специализированный микропроцессор, спроектированный для быстрого рендеринга графики и одновременной обработки значительных объемов данных. Подробнее о том, как он устроен, вы узнаете из нашего материала.

Что такое GPU

Изначально GPU создавали для ускорения отрисовки 3D-сцен в играх и профессиональных графических пакетах, но со временем сфера применения резко расширилась. Сегодня графический чип помогает обрабатывать данные в научных исследованиях, машинном обучении, финансовом анализе и многих других направлениях, где ценится высокая производительность при параллельной работе.

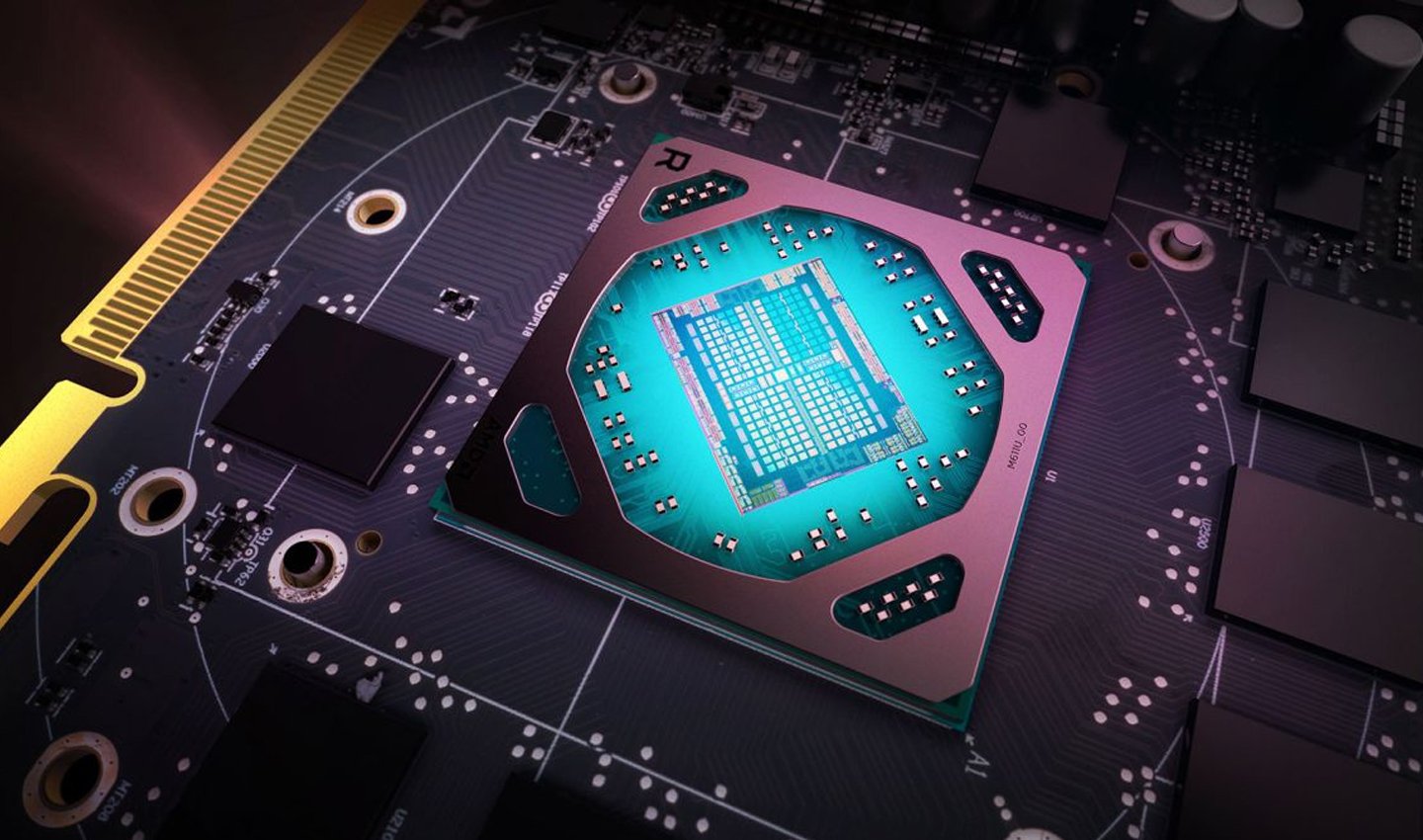

Источник: News.1k / Микропроцессор

Источник: News.1k / Микропроцессор

Главная особенность GPU заключается в его архитектуре. Здесь сосредоточено большое количество потоковых вычислительных блоков, способных выполнять одни и те же инструкции над множеством элементов. Такой подход называется SIMD (single instruction, multiple data) и позволяет в буквальном смысле за один такт производить множество однотипных операций над пикселями, вершинами 3D-моделей или элементами матриц.

В то время как CPU оперирует меньшим количеством более сложных ядер, GPU делает ставку на массовый параллелизм. Это значит, что он идеально подходит для отрисовки кадров в реальном времени и для задач, связанных с линейной алгеброй, где одну формулу нужно многократно повторить над обширными наборами данных.

Начало истории: от простых графических адаптеров до универсальных GPU

В конце 1970-х и начале 1980-х годов разработчики сосредоточились на повышении удобства работы с компьютерами, и первое, что требовалось пользователям, — возможность видеть на экране текст, графику и примитивные картинки. Простые адаптеры вроде MDA (Monochrome Display Adapter) выводили монохромные символы, а CGA (Color Graphics Adapter) добавлял цвет, но все эти операции фактически обеспечивались центральным процессором, который был загружен графическими расчетами.

Источник: Нейросеть Dalle / Встроенная видеокарта

Источник: Нейросеть Dalle / Встроенная видеокарта

Затем появилась более продвинутая система VGA (Video Graphics Array), которая повысила качество и разрешение выводимого изображения. С развитием трехмерной графики, особенно в компьютерных играх, стало ясно, что CPU с трудом справляется с потоком однообразных вычислительных операций, которые требовались для отрисовки сцены. Решение предложили производители 3D-ускорителей — они разместили отдельный микрочип, ориентированный на графику, на печатной плате (видеокарте).

Настоящий прорыв произошел в конце 1990-х годов, когда компания NVIDIA представила линейку GeForce, а термин «GPU» (Graphics Processing Unit) вошел в обиход. Новые чипы уже не были просто «ускорителями» — они представляли собой полноценные процессоры с набором вычислительных блоков, которые умели выполнять рендеринг, трансформацию и освещение геометрии, разгружая центральный процессор. С тех пор рост производительности был колоссальным: за каждое новое поколение GPU увеличивались тактовые частоты, появлялась более быстрая видеопамять, а архитектура становилась более гибкой для широкого спектра задач.

GPU и видеокарта: почему эти понятия не равнозначны

Графический процессор (GPU) и видеокарта (графический адаптер) — термины, которые иногда ошибочно используют как синонимы, хотя они обозначают разные вещи. GPU — это сам полупроводниковый чип, состоящий из тысяч потоковых ядер, систем контроля и управляющих элементов. Видеокарта же — это полноценное устройство, включающее в себя несколько обязательных компонентов.

Источник: Нейросеть Dalle / GPU и видеокарта

Источник: Нейросеть Dalle / GPU и видеокарта

На ней обязательно размещен сам GPU, который выполняет параллельные вычисления. Кроме того, карта содержит видеопамять (VRAM) — здесь сохраняются текстуры, буферы кадров, дополнительные служебные данные. На карте также располагается система питания, гарантирующая стабильную работу при высоких нагрузках, и выводы для подключения дисплеев (HDMI, DisplayPort).

В системах типа ноутбуков или маломощных десктопов нередко используют интегрированный GPU, встроенный в общий кристалл вместе с CPU. Это решение экономит место и снижает стоимость, хотя и ограничивает производительность. Напротив, полноценная дискретная карта с отдельным графическим процессором предназначена для ресурсоемких задач: тяжелых игр, 3D-моделирования, научных вычислений.

Разница в подходе отражает разные потребности рынков: универсальные устройства с компактным форм-фактором против высокопроизводительных систем, которым нужно максимум мощности.

Встроенный и дискретный GPU: отличия и основные характеристики

Интегрированный (встроенный) GPU обычно встречается в чипах, где центральный и графический процессоры находятся в одном корпусе. Этот вариант часто называют iGPU. Он потребляет меньше энергии, что важно для ноутбуков и ультрабуков, где каждый ватт на счету. Кроме того, такие системы меньше греются. Но у iGPU нет собственной видеопамяти, поэтому он расходует часть обычной оперативной памяти.

Источник: Mobez / Встроенная видеокарта

Источник: Mobez / Встроенная видеокарта

В результате производительность при сложных графических эффектах или 3D-приложениях оказывается заметно ниже, чем у дискретных решений. Тем не менее встроенного GPU обычно достаточно для офисного софта, веб-серфинга, работы с документацией и воспроизведения видео, а некоторые современные iGPU справляются даже с нетребовательными играми.

Дискретный GPU располагается на самостоятельной печатной плате (видеокарте) с собственной высокоскоростной памятью (GDDR6 или ее более новые версии) и отдельной подсистемой питания. Такое решение гарантирует, что графика работает независимо от центрального процессора и не отбирает оперативную память у системы.

Источник: Нейросеть Dalle / ПК с дискретной видеокартой

Источник: Нейросеть Dalle / ПК с дискретной видеокартой

Дискретные видеокарты бывают разного уровня: от бюджетных моделей для простых игр и рутинных задач до топовых устройств, предназначенных для профессиональных рабочих станций и систем машинного обучения. В игровых ноутбуках тоже ставят специальные мобильные графические модули, благодаря которым пользователи могут запускать современные игры на высоких настройках, несмотря на портативность самого компьютера.

Почему GPU так хорошо справляется с параллельными вычислениями

Главное отличие GPU от CPU — архитектура, которая ориентирована на массовый параллелизм. В CPU обычно несколько мощных универсальных ядер, каждое из которых способно выполнять сложные инструкции и обрабатывать разные потоки. Такие ядра справляются с ветвлениями кода, логикой и многозадачностью. Однако если требуется многократно повторить одинаковые вычисления над большим числом элементов, CPU быстро достигает предела производительности.

Источник: Нейросеть Dalle / Архитектура GPU

Источник: Нейросеть Dalle / Архитектура GPU

GPU, наоборот, состоит из сотен и тысяч маленьких потоковых блоков, которые могут одновременно выполнять одну и ту же операцию над разными частями данных. Именно это называется SIMD-подходом. Массовый параллелизм используется для рендеринга пикселей в 3D-сцене, умножения матриц при обучении нейронных сетей, фильтрации изображений и других задач, в которых одна и та же процедура применяется к массивам, состоящим из огромного количества элементов.

Графический конвейер: этапы построения изображения

Чтобы на экране появилось полноценное 3D-изображение, GPU проходит несколько фаз, которые обычно называют графическим конвейером. Сначала идет обработка вершин, где каждая вершина (точка, описывающая геометрию объекта) получает свои координаты и данные об освещении, текстурах, цвете. Затем вершины преобразуются матрицами, учитывающими положение камеры, перспективу и углы обзора. На следующем этапе формируются примитивы (чаще треугольники).

После этого начинается растеризация: конвейер вычисляет, какие пиксели на экране попадают внутрь каждого треугольника, а также каково их освещение и цвет. Далее пиксели дополняются текстурами, тенями, отражениями — для этого используются пиксельные (фрагментные) шейдеры, которые представляют собой короткие программы, описывающие, как надо обработать каждый пиксель. Когда все расчеты завершены, итоговые данные складываются в кадровый буфер, и изображение готово к выводу на дисплей.

Подобная система работает очень быстро за счет того, что GPU одновременно обрабатывает множество вершин и пикселей. Разработчики игр и приложений получают возможность писать собственные шейдеры (вершинные, пиксельные, геометрические и т. д.), чтобы придавать объектам нужные эффекты — например, реалистичные блики или объемное освещение.

Применение в игровой индустрии: реалистичная графика и физика

В игровой сфере GPU долгое время воспринимался как простой способ повысить кадровую частоту и улучшить визуальные эффекты, но теперь его роль выходит далеко за рамки обычной отрисовки. Благодаря шейдерной архитектуре возможно динамическое освещение, моделирование тканевых и дымовых эффектов, симуляции жидкостей и даже просчет физики частиц.

Источник: Artstation / Cryengine 5.4

Источник: Artstation / Cryengine 5.4

Современные движки (Unity, Unreal Engine, CryEngine) позволяют разработчикам глубоко интегрировать GPU-функциональность для отображения больших игровых миров без заметной просадки FPS. Технологии вроде PhysX (NVIDIA) или Liquid Physics (AMD) переносят часть расчетов по взаимодействию тел и частиц на видеочип, разгружая CPU. Таким образом, компьютерная игра выглядит кинематографично и плавно движется даже при сложной геометрии и богатых сценах.

Игровые приложения используют и современные алгоритмы трассировки лучей (ray tracing), чтобы добиться фотореалистичного освещения и отражений. Подобные расчеты связаны с гигантским количеством вычислительных операций над пикселями, ведь нужно учитывать поведение лучей света при отражении и преломлении. Как следствие, GPU неизбежно стал основным двигателем для такой графики.

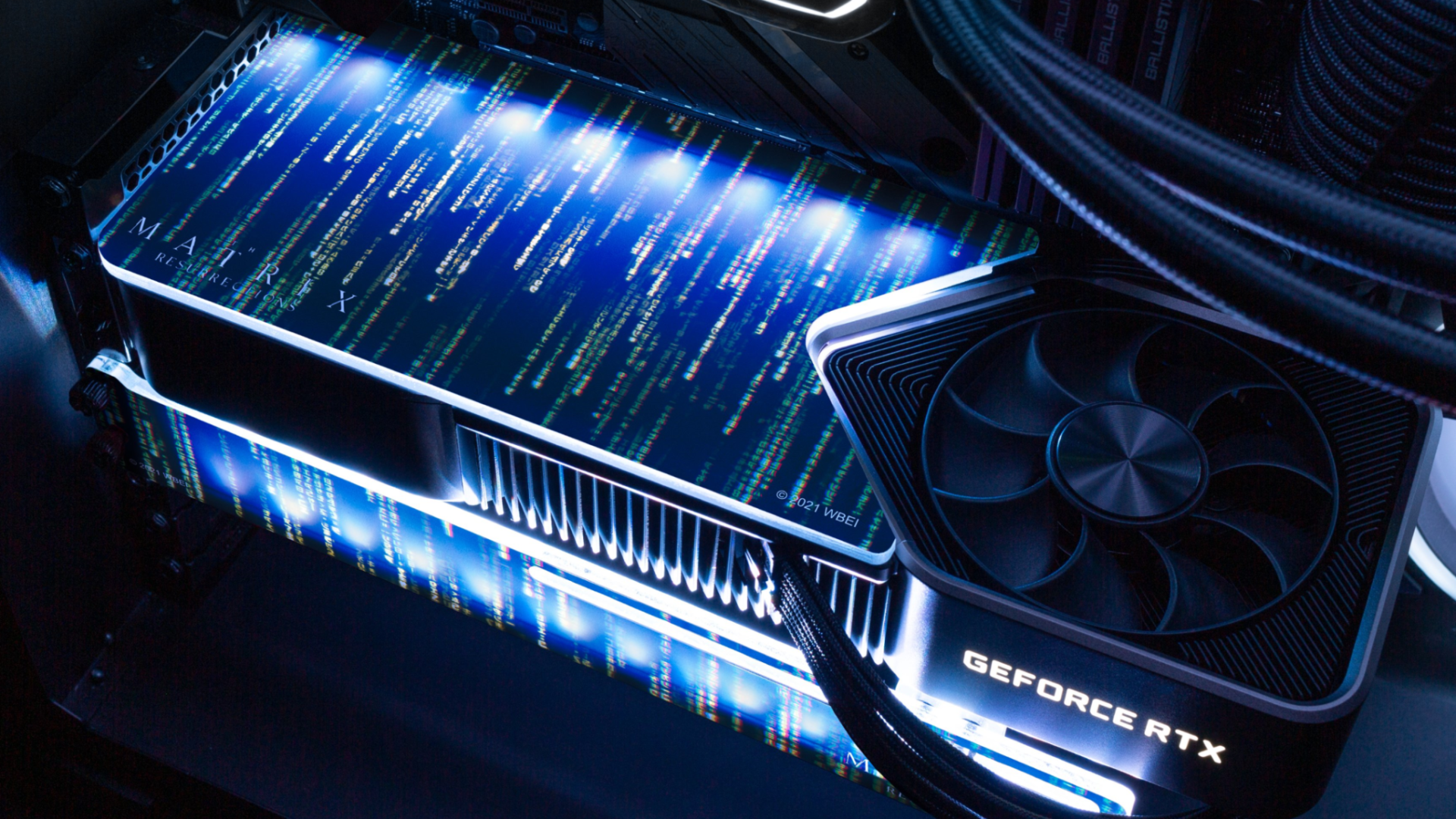

Заглавное фото: Sftgroup

Дмитрий «Capi26» Колдушко

Дмитрий «Capi26» Колдушко

0 комментариев